Le géant de la tech envisage de faire scanner les appareils de ses utilisateurs pour lutter contre la pornographie infantile. Tollé des défenseurs de la vie privée qui redoutent qu’un tel dispositif ne soit détourné de son objectif initial.

Apple serait-il prêt à abandonner son sacro-saint principe du respect de la vie privée ? La question est sur les lèvres depuis la dernière annonce du constructeur d’appareils électroniques il y a quelques jours. Le 5 août dernier, la firme de Cupertino annonçait en effet vouloir déployer prochainement un nouveau dispositif appelé « NeuralMatch« . Celui-ci pourra passer en revue grâce à l’intelligence artificielle, toutes les photos stockées sur les appareils de la marque à la pomme afin d’y débusquer de potentielles images explicites d’enfants.

Cela suppose que toute la galerie des utilisateurs d’iPhone, d’iPad ou de MacBook sera à la merci d’Apple. Et dans le cas de la détection d’une image ayant trait à la pédopornographie, une alerte est envoyée à un employé qui analyse le cliché pour confirmation.

Visée noble

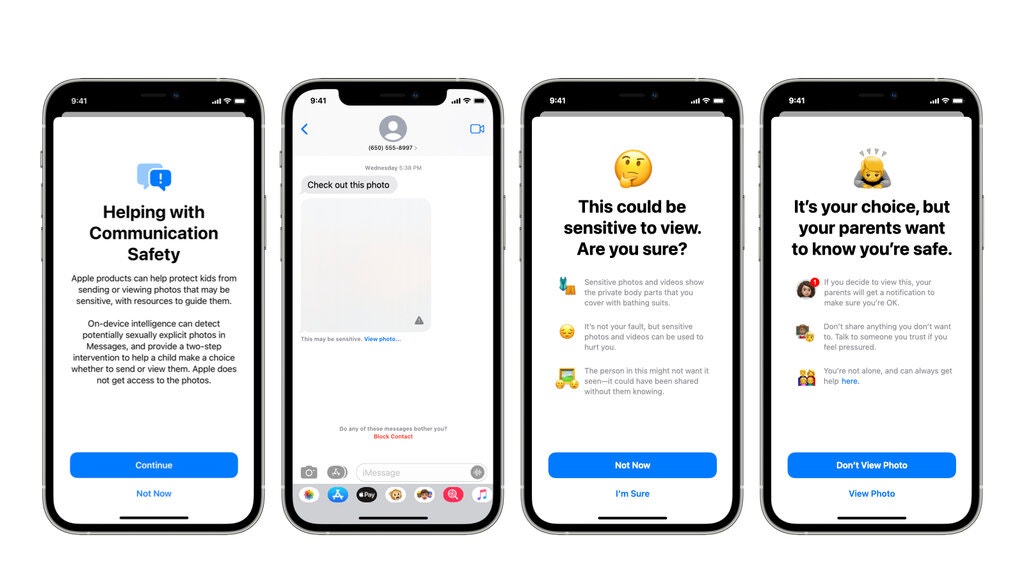

NeuralMatch devrait permettre selon Apple, de mener la vie dure aux promoteurs de l’exploitation sexuelle des enfants. D’autant qu’il intègre aussi une fonctionnalité susceptible d’alerter les parents quand leur enfant reçoit sur son smartphone une photo à caractère sexuel. L’entreprise de Tim Cook souvent pointée du doigt ces dernières années par les autorités gouvernementales et les services de sécurité pour son manque de coopération aux procédures criminelles, s’est associée avec la National Center for Missing and Exploited Children (NCEM), une organisation à but non lucratif soutenue par le Congrès américain dans ce cadre. C’est donc avec satisfecit que les responsables gouvernementaux ont accueilli la perspective de cette mise à jour à venir.

Une brèche dangereuse

Mais cela ne réjouit pas particulièrement les défenseurs de la vie privée en ligne, qui y voient une porte ouverte à tous les abus. D’autant qu’Apple a déjà accès aux photos de ses utilisateurs stockées sur son serveur icloud. Peut-on s’autoriser le droit de s’incruster ainsi dans la galerie de l’appareil d’un utilisateur même si l’objectif est par ailleurs noble ? Où s’arrête la frontière entre vie privée et la sécurité publique ? Voilà autant de questions que suscite NeuralMatch, un outil reflétant selon ses détracteurs, une nouvelle étape du reniement progressif par Apple de ses valeurs pour la protection des données.

Pas sûr que les critiques fassent reculer le créateur d’iPhone, qui a manifestement décidé d’agir davantage contre les contenus illégaux sur ses plateformes.